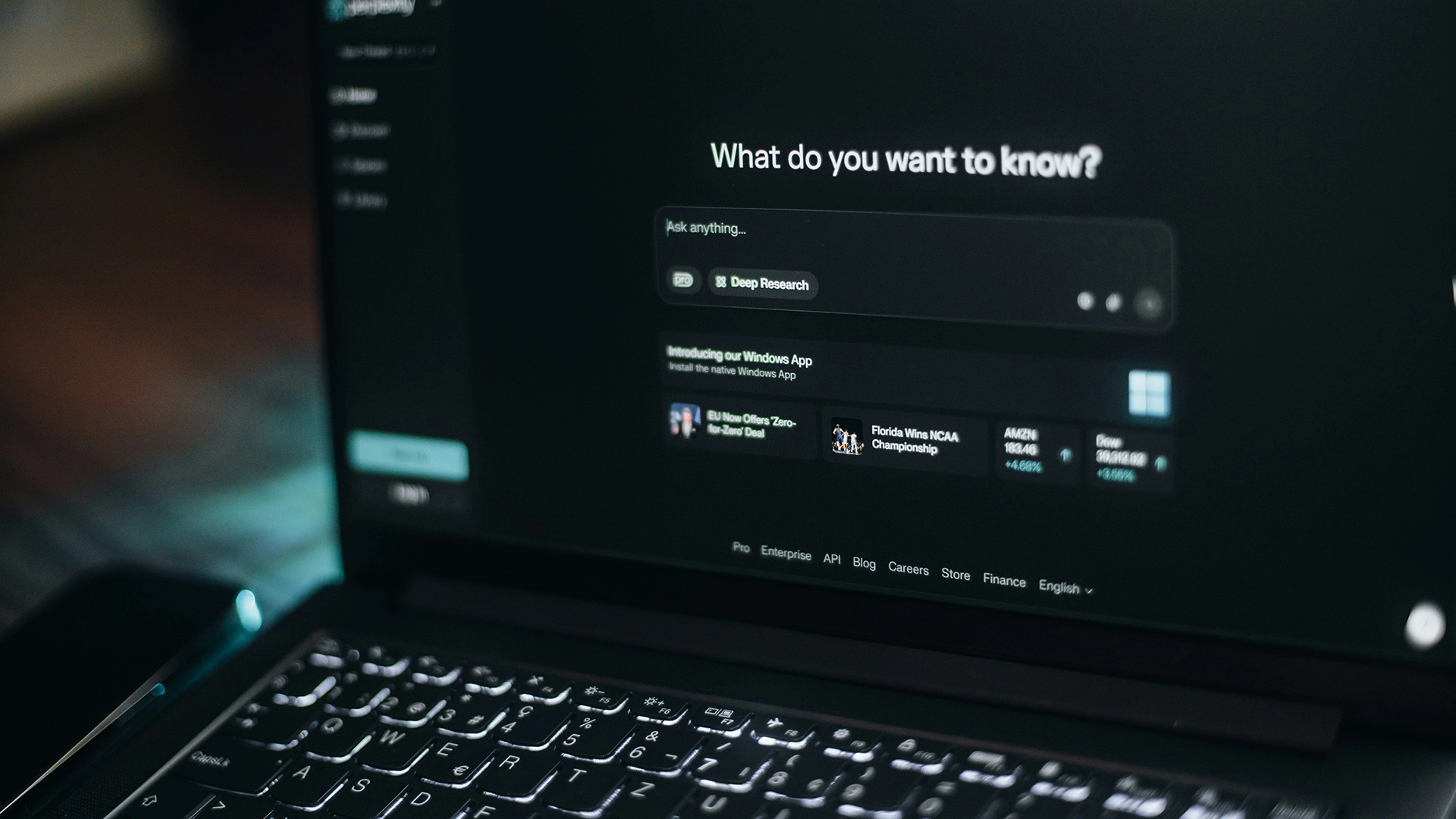

Image by Aerps.com, from Unsplash

Одна треть ответов AI-поиска содержит неподтвержденные утверждения, утверждает исследование

Новое исследование утверждает, что инструменты искусственного интеллекта, созданные для ответа на вопросы и проведения онлайн-исследований, испытывают трудности в выполнении своих обещаний.

Спешите? Вот краткие факты:

- GPT-4.5 представил неподтвержденные утверждения в 47% ответов.

- Агент глубокого исследования Perplexity выдвинул неподтвержденные утверждения в 97.5% случаев.

- Инструменты часто представляют односторонние или слишком уверенные ответы на вопросы дебатов.

Исследователи сообщили, что примерно треть ответов, данная генеративными поисковыми системами AI и глубокими исследовательскими агентами, содержали необоснованные утверждения, и многие из них были представлены предвзятым или односторонним способом.

Исследование, которым руководил Пранав Нараянан Венкит из Salesforce AI Research, тестировало системы, такие как OpenAI’s GPT-4.5 и 5, Perplexity, You.com, Bing Chat от Microsoft и Google Gemini. На протяжении 303 запросов ответы оценивались по восьми критериям, включая то, подкреплены ли утверждения источниками.

Результаты были тревожными. GPT-4.5 выдавал необоснованные утверждения в 47 процентах ответов. У Bing Chat такие утверждения встречались в 23 процентах случаев, в то время как You.com и Perplexity достигли примерно 31 процента.

Агент глубокого исследования Perplexity показал худший результат, 97,5 процентов его утверждений не подтвердились. «Мы определенно были удивлены, увидев это», — сказал Нараянан Венкит New Scientist.

Исследователи объясняют, что генеративные поисковые движки (GSEs) и агенты глубокого исследования (DRs) должны собирать информацию, ссылаться на надежные источники и предоставлять детализированные ответы. Однако на практике они часто терпят неудачу.

Рамка оценки, названная DeepTRACE, показала, что эти системы часто дают «однобокие и излишне уверенные ответы на вопросы для дебатов и включают большое количество утверждений, не подкрепленных их собственными перечисленными источниками», как отметили исследователи.

Критики предупреждают, что это подрывает доверие пользователей. New Scientist сообщает, что Феликс Саймон из Университета Оксфорда сказал: «Было много жалоб от пользователей и различных исследований, показывающих, что несмотря на значительные улучшения, AI системы могут давать однобокие или вводящие в заблуждение ответы».

«Таким образом, эта статья предоставляет некоторые интересные данные по этой проблеме, которые, как мы надеемся, помогут стимулировать дальнейшие улучшения в этом направлении», — добавил он.

Некоторые подвергли сомнению методы, но согласились, что надежность и прозрачность остаются серьезными проблемами. Как заключили исследователи, «текущие общественные системы не оправдывают своих обещаний по предоставлению достоверных, основанных на источниках синтезов».

Предыдущая история

Предыдущая история

Последние статьи

Последние статьи