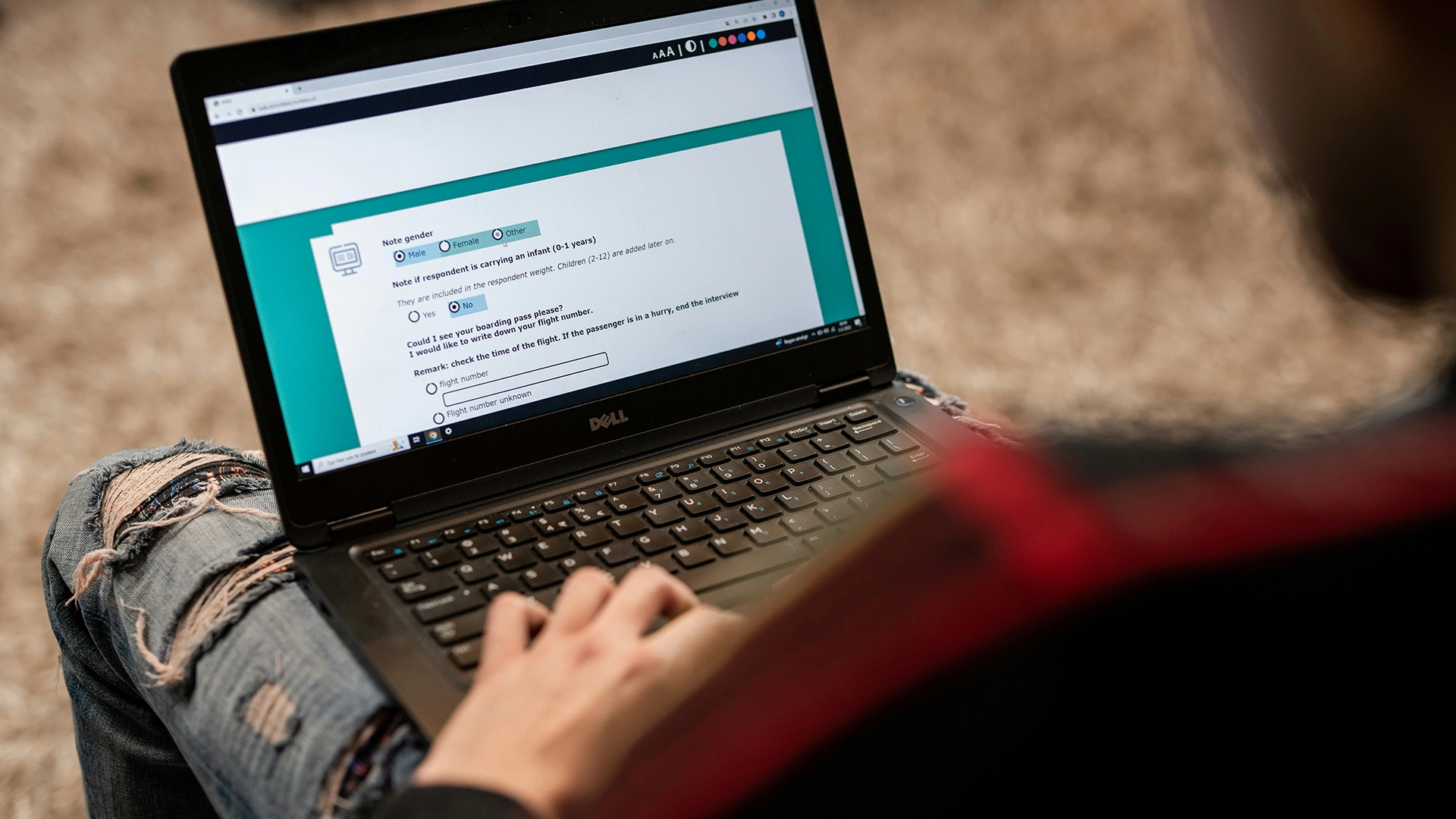

Image by ODISSEI, from Unsplash

Почти половина ответов на онлайн-опросы может приходить от искусственного интеллекта, говорится в исследовании.

Онлайн-исследования поведения, которые ранее считались надежным методом изучения человеческой психологии, теперь сталкиваются с серьезной проблемой, поскольку участники используют инструменты ИИ, такие как чат-боты, для формирования своих ответов.

Спешите? Вот краткие факты:

- 45% участников опроса Prolific использовали ответы, сгенерированные искусственным интеллектом.

- Исследователи обнаружили, что текст чат-бота часто выглядит «чрезмерно многословным» или «нечеловеческим».

- Эксперты называют эту проблему «загрязнением LLM», которое угрожает достоверности исследований поведения.

Исследователи из Института развития человека Макса Планка в Берлине недавно изучали распространенность проблемы на платформах вроде Prolific, которые платят добровольцам за прохождение опросов.

«Частота случаев, которую мы наблюдали, была действительно потрясающей», — говорит ведущий исследователь Анна-Мари Нуссбергер, как сообщает New Scientist (NS).

В одном из тестов 45 процентов участников, по-видимому, вставляли содержимое, сгенерированное чат-ботом, в поле для ответа с открытым концом. Ответы часто демонстрировали признаки, такие как «чрезмерная многословность» или «явно нечеловеческий» язык.

«Исходя из данных, которые мы собрали в начале этого года, выглядит так, что значительная доля исследований контаминирована», — сказала Нуссбергер NS.

Чтобы выявить подозрительные ответы, ее команда внедрила скрытые ловушки. Базовые reCAPTCHA пометили 0,2 процента пользователей, более продвинутая версия поймала 2,7 процента, невидимый текстовый запрос, который просил слово «hazelnut», поймал 1,6 процента, а запрет на копирование и вставку обнаружил еще 4,7 процента.

Проблема превратилась в то, что эксперты теперь называют «загрязнением LLM», которое выходит за рамки обмана. Исследование показывает три модели вмешательства ИИ: Частичное посредничество (ИИ помогает с формулировкой или переводом), Полная делегация (ИИ проводит полные исследования) и Перелив (люди изменяют свои действия, потому что они ожидают присутствия ИИ).

«То, что нам нужно сделать, — это не полностью недоверять онлайн-исследованиям, а реагировать и отвечать», — говорит Нуссбергер, призывая платформы принять проблему всерьез, как сообщает NS..

Мэтт Ходжкинсон, консультант по вопросам исследовательской этики, предупреждает NS: «Честность онлайн-исследований поведения уже ставилась под сомнение […] Исследователям либо нужно совместно разрабатывать способы удаленной проверки участия людей, либо вернуться к старомодному подходу личного общения.»

Prolific отказался комментировать ситуацию NS.

Предыдущая история

Предыдущая история

Последние статьи

Последние статьи